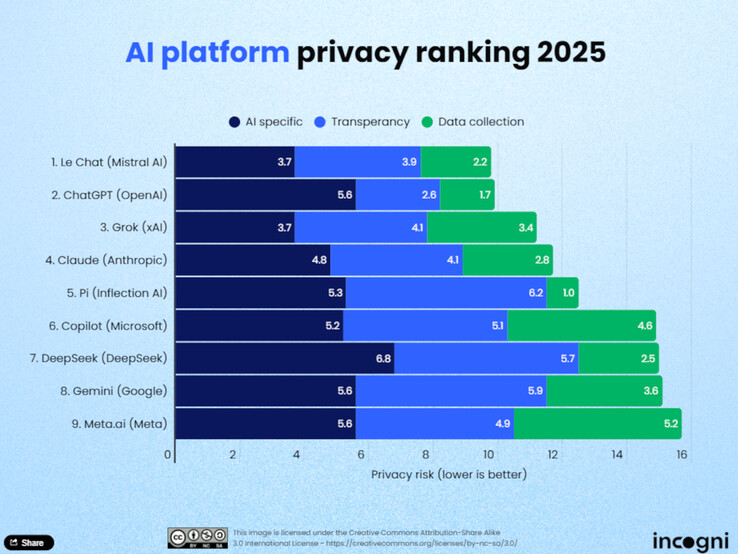

A mesterséges intelligencia (AI) használata a mindennapi életben egyre nagyobb teret nyer, és ezzel együtt az adatvédelem fontossága is növekszik. A Incogni adatvédelmi elemzői nemrégiben kilenc vezető nagy nyelvi modellt (LLM) értékeltek, hogy meghatározzák, mely platformok tartják tiszteletben leginkább a felhasználók adatvédelmét. A tanulmány tizenegy kritérium alapján értékeli az AI-modelleket, amelyek három fő kategóriába sorolhatók: adatgyűjtés a képzéshez, átláthatóság, valamint az adatok felhasználása és megosztása.

Legjobb helyezések

A rangsort a Mistral AI Le Chat vezeti. Az Incogni szerint a modell viszonylag kevés felhasználói adatot gyűjt, és nagyon adattakarékos megközelítést kínál mind a képzési szakaszban, mind az éles üzemben. Szorosan a nyomában az OpenAI-tól származó ChatGPT következik, amely elsősorban az átláthatóságával szerez pontot. A felhasználók a fiókjukban külön megadhatják, hogy a csevegéseiket fel lehet-e használni a modell továbbfejlesztéséhez, és ha az előzményeket kikapcsolják, a tárolást megakadályozzák. A harmadik helyen az xAI Grok áll, amely szintén az átlátható adatvédelmi gyakorlatával nyűgöz le.

A rangsor utolsó helyezettje

A rangsor végén a Meta AI, a Google Gemini és a Microsoft Copilot áll. Az Incogni szerint ezek a platformok széles körű adatgyűjtést végeznek anélkül, hogy a felhasználóknak egyértelmű opt-out lehetőségeket kínálnának. A DeepSeek, egy kínai modell szintén rosszul teljesít. Ezek a szolgáltatók nem kínálnak egyértelmű lehetőségeket a felhasználói adatok képzésből való kizárására.

Módszertan

Az Incogni elemzői tizenegy kritérium alapján értékelték a platformokat, amelyeket három kategóriába soroltak: adatgyűjtés a képzéshez, átláthatóság, valamint az adatok felhasználása és megosztása. Az "adatfelhasználás és -megosztás" kategória az általános értékelés 50%-át tette ki, míg az "átláthatóság" 30%-ot, a "képzési adatok" pedig 20%-ot. A kilenc tesztelt eszköz közül csak négy teszi lehetővé a felhasználók számára, hogy aktívan kizárják adataikat a képzésből.

Következtetés

A tanulmány azt mutatja, hogy az adatvédelem még nem mindenhol szabványos a mesterséges intelligencia világában. A felhasználóknak ezért aktívan meg kell ismerkedniük a szolgáltatók adatvédelmi irányelveivel, különösen, ha érzékeny tartalmakról, bizalmas ügyféladatokról vagy személyes adatokról van szó. Azok, akiknek fontos az adatvédelem, a Le Chat, a ChatGPT vagy a Grok kínálatában ésszerű lehetőségeket találnak. A valóban adattakarékos LLM-ek azonban 2025-ben még mindig a kivételek közé tartoznak.

Forrás(ok)

» A Top 10 multimédiás noteszgép - tesztek alapján

» A Top 10 játékos noteszgép

» A Top 10 belépő szintű üzleti noteszgép

» A Top 10 üzleti noteszgép

» A Top 10 notebook munkaállomása

» A Top 10 okostelefon - tesztek alapján

» A Top 10 táblagép

» A Top 10 Windows tabletje

» A Top 10 subnotebook - tesztek alapján

» A Top 10 300 euró alatti okostelefonja

» A Top 10 120 euró alatti okostelefonja

» A Top 10 phabletje (>5.5-inch)

» A Top 10 noteszgép 500 EUR (~160.000 HUF) alatt

» A Top 10 "pehelysúlyú" gaming notebookja