Az Epic vezérigazgatója Tim Sweeney nemrégiben figyelmeztette a hogy a prémium játékszámítógépek piacát belátható időn belül veszélyeztetik a grafikus memóriák túlzott árai.

A PC- és laptopgyártók egyszerűen nem tudnak versenyezni azokkal az árakkal, amelyeket az olyan AI-óriások, mint az Nvidia, a Google, a Meta és mások hajlandóak kifizetni a csúcskategóriás GPU- és AI-adatközpont-projektjeik fejlesztéséért - figyelmeztetett Sweeney. Figyelmeztetése a RAM-árak emelkedését kommentálta: az egyik felhasználó arra panaszkodott, hogy ugyanaz a 64 GB-os Crucial RAM-egység, amelyet egy hónapja 240 dollárért vásárolt, most több mint kétszeresére, közel 500 dollárra drágult. Az Amazon jelenleg a két 32 GB-os modult kedvezőbb áron kínálja, ami még mindig jóval magasabb, mint amennyibe októberben került.

Samsung és SK Hynix HBM4 memória ára az Nvidia számára

Véletlenül éppen 500 dollárt készül az Nvidia a hírek szerint fizetni mind a Samsungnak, mind az SK Hynixnek a következő generációs memóriáért HBM4 grafikus memóriáért 2026-ban. Iparági bennfentesek szerint a memóriagyártók akár 100%-kal többet kérnek az Nvidia-tól, mert megtehetik. Az SK Hynix HBM4 memória gyártási költségei 50%-kal emelkednek, mivel a TSMC-nél kell gyártania az alap die-t, de ezt a növekedést teljes egészében az Nvidia fogja áthárítani. Jelenleg az SK Hynix a 12 rétegű HBM3E memóriamoduljait darabonként körülbelül 350 dollárért adja el az Nvidia számára, míg a Samsung 100 dollárral kevesebbért, mivel a tanúsítási problémák miatt későn érkezett a buliba.

2026-ban az Nvidia AI-chipjeihez szánt csúcskategóriás HBM4 memória ára 500 dollár közepén lesz, ami a Samsung esetében több mint kétszerese lesz annak, amit a HBM3E elődjéért kérnek."Az Nvidia HBM4 iránti kereslete olyan nagy, hogy a Samsung Electronicsnak nincs más választása, mint magas áron biztosítani az ellátást" - tippelnek a bennfentesek. Mondani sem kell, hogy ez az Nvidia magasabb árait is eredményezheti, hiszen GPU-jai iránt nincs hiány kereslet.

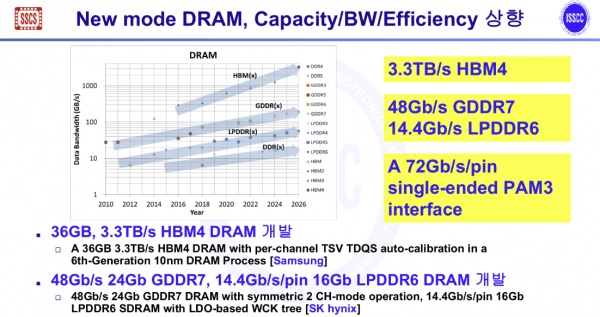

Az SK Hynix GDDR7 és LPDDR6 memória specifikációi

A Samsung HBM4 memória ára mellett az iparági források részletesen ismertették annak felülvizsgált specifikációit is. A Samsung a jelek szerint újratervezte az interfészt és a stacking architektúrát, hogy a 36 GB kapacitású modul 3,3 TB/s sávszélességet érjen el. A frissítések közé tartozika "javított jelpontosság a nagysebességű szakaszokban azáltal, hogy automatikus kompenzációt alkalmaznak a csatornaspecifikus, szilíciumon átvezető (TSV) útvonal összehangolási jelére (TDQS)", vagyis az AI gyorsító és LLM-specifikus forgalmat feldolgozó útvonalra. Összehasonlításképpen: a jelenlegi HBM3E modulok, amelyeket a Samsung az Nvidia számára értékesít, 1,2 TB/s-os specifikációval rendelkeznek, így a HBM4 modul több mint kétszeres sávszélességet kínál majd, kétszeres áron.

Az új HBM4 specifikáció részletei mellett az SK Hynix képviselője megismételte az LPDDR6 és GDDR7 memória specifikációit is. Az LPDDR6 mobil DRAM-modulok 14,4 Gb/s átviteli sebességet kínálnak minden egyes csapon, új, alacsony feszültségű szabályozó technológiával, amely stabilan tartja a jelet a megnövelt sebesség mellett is. A 24 GB-os GDDR7 grafikus memóriamodulok ezzel szemben a csúcskategóriás játékokat és az AI következtetési feladatokat célozzák meg, tűnként 48 Gb/s-os sebességgel, vagyis a jelenlegi SK Hynix GDDR6 modulok sávszélességének háromszorosával.

A Samsung és az SK Hynix következő generációs HBM4, LPDDR6 és GDDR7 memóriatechnológiáit a februárban San Franciscóban megrendezésre kerülő International Solid-State Circuits Conference (ISSCC) konferencián mutatják be. A Samsung ezt követően várhatóan a második negyedévben gyorsított ütemezéssel, a jelenlegi ár duplájáért kezdi meg a HBM4 modulok szállítását az Nvidia számára, ami valószínűleg drágább Nvidia GPU-kat jelentene 2026-ban.

Az ASUS ROG Astral GeForce RTX 5080 OC Edition játék GPU megvásárolható az Amazonon

Forrás(ok)

Az Elec & Dealsite via TrendForce

» A Top 10 multimédiás noteszgép - tesztek alapján

» A Top 10 játékos noteszgép

» A Top 10 belépő szintű üzleti noteszgép

» A Top 10 üzleti noteszgép

» A Top 10 notebook munkaállomása

» A Top 10 okostelefon - tesztek alapján

» A Top 10 táblagép

» A Top 10 Windows tabletje

» A Top 10 subnotebook - tesztek alapján

» A Top 10 300 euró alatti okostelefonja

» A Top 10 120 euró alatti okostelefonja

» A Top 10 phabletje (>5.5-inch)

» A Top 10 noteszgép 500 EUR (~160.000 HUF) alatt

» A Top 10 "pehelysúlyú" gaming notebookja