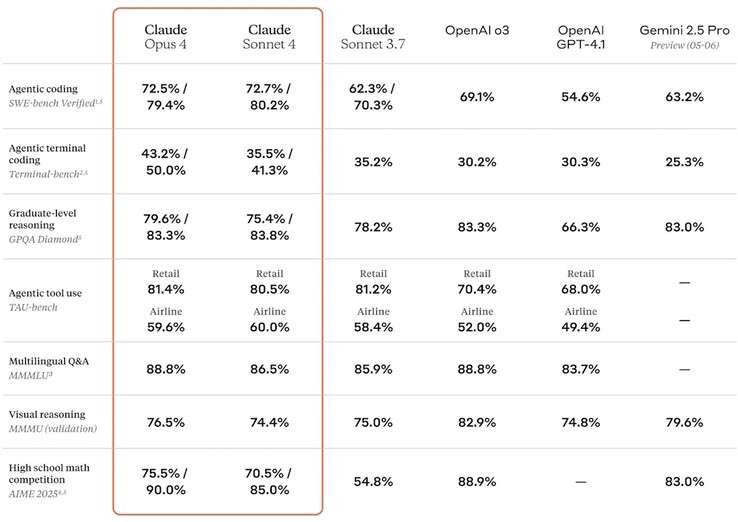

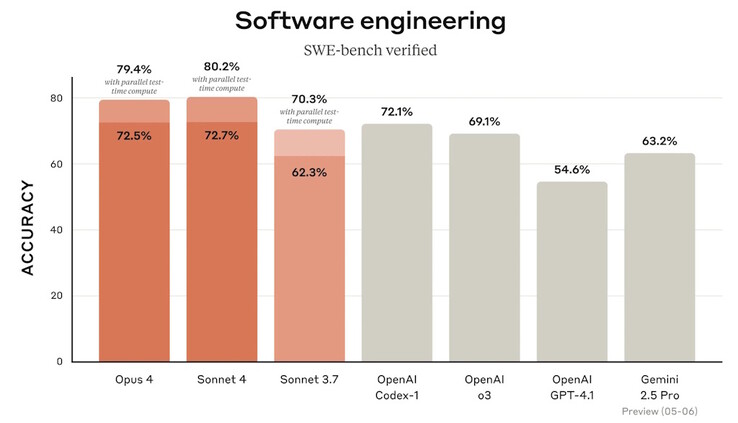

Az Anthropic kiadta a Claude Opus 4-et és Claude Sonnet 4 mesterséges intelligencia modelleket továbbfejlesztett pontossággal, képességekkel és teljesítménnyel.

Az Opus a vállalat legokosabb modellje, amely képes megállás nélkül, órákon át dolgozni összetett és nehéz problémákon. Egyes korai felhasználók szerint hét órán keresztül dolgozott önállóan programozási feladatokon, és a mesterséges intelligencia jobban emlékszik a bemeneti adatokra és az eredményekre a jobb válaszok érdekében. A Sonnet az általános modellje az általános kérésekre adott gyors válaszokhoz. Mindkettő javított kódolási pontossággal segíti a programozókat a legújabb alkalmazások létrehozásában.

Mindkét modell képes adatelemzőként működni, Python kódot írva elemezni és vizualizálni az adathalmazokat. Számos új API-funkció lehetővé teszi a vállalatok számára, hogy testreszabott alkalmazásokat hozzanak létre, amelyek integrálják a Claude-ot a jobb üzleti adatelemzés és funkcionalitás érdekében. A Claude Code lehetővé teszi, hogy a mesterséges intelligencia olyan népszerű IDE-kben működjön, mint a VS Code és a JetBrains, hogy segítse a programozókat a jobb kódolásban.

Az Anthropic aktiválta a AI Safety Level 3 (ASL-3) telepítési és biztonsági szabványait a Claude Opus 4 elővigyázatossági szintjét, mivel a vállalat még nem zárta ki annak lehetőségét, hogy az AI veszélyes cselekedetekre képes, például arra, hogy feltörjék és vegyi, biológiai, radiológiai és nukleáris (CBRN) fegyverek létrehozására használják.

Azok az olvasók, akik a munkahelyükön szeretnék megtapasztalni az antropikus mesterséges intelligencia előnyeit, a Plaude Note vagy a Plaude NotePin segítségével automatikusan összefoglalhatják és átírhatják az órákat és megbeszéléseket. Azok, akik otthonról dolgoznak, a után beszélgethetnek Claude-dal, letöltve az Anthropic alkalmazást laptopokra és okostelefonokra.

Forrás(ok)

» A Top 10 multimédiás noteszgép - tesztek alapján

» A Top 10 játékos noteszgép

» A Top 10 belépő szintű üzleti noteszgép

» A Top 10 üzleti noteszgép

» A Top 10 notebook munkaállomása

» A Top 10 okostelefon - tesztek alapján

» A Top 10 táblagép

» A Top 10 Windows tabletje

» A Top 10 subnotebook - tesztek alapján

» A Top 10 300 euró alatti okostelefonja

» A Top 10 120 euró alatti okostelefonja

» A Top 10 phabletje (>5.5-inch)

» A Top 10 noteszgép 500 EUR (~160.000 HUF) alatt

» A Top 10 "pehelysúlyú" gaming notebookja