A Samsung szállítja az Nvidia valaha megrendelt legdrágább AI memóriáját, mivel a HBM4 meghaladja a legfontosabb specifikációkat

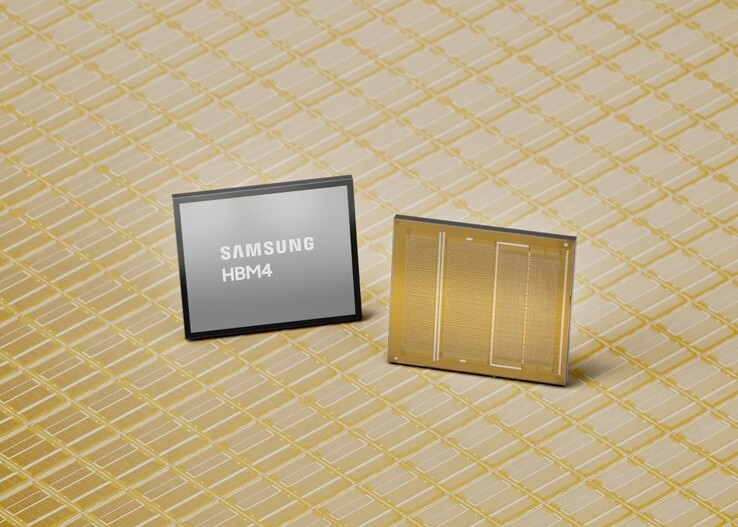

A Samsung bejelentette a következő generációs HBM4 memória első kereskedelmi szállítását olyan alkalmazásokhoz, mint az Nvidia GPU-k és a megfelelő AI adatközpontok.

Az Nvidia és más ügyfelek állítólag fizetnek a közel 500 dollárt fizetnek darabonként a Samsungnak, ami kétszerese annak, amit a korábbi, nagy sávszélességű HBM3E memóriagenerációért fizettek. Ennek következtében a Samsung részvényei történelmi csúcson vannak, és a vállalat vezetése újabb sikertörténeti évre számít az általános memóriamegosztáson felbuzdulva hiányra.

A Samsung HBM4 memória adatai

Míg a memóriagyártók jelenleg minden legyártott egységért drágán kérnek, a Samsung szerint az új HBM4 AI memóriájának sikerült túlteljesítenie mind a Joint Electron Device Engineering Council (JEDEC) szabványát, mind az Nvidia követelményeit.

A HBM4 működési sebessége elérheti a 13 Gbps-ot, ami 46%-kal magasabb a JEDEC követelményeinél, a teljes memória sávszélessége pedig akár 3,3 TB/s is lehet vermenként, ami messze meghaladja az olyan ügyfelek által kért 3 TB/s-os sebességet, mint az Nvidia.

A Samsung ezt a nyaktörő átviteli sebességet úgy érte el, hogy a HBM3 elődjéhez használt 14 nm-es 1a DRAM-mal szemben a 10 nm-es, 6. generációs 1c DRAM-eljárást alkalmazta a 4 nm-es alaplapkával. Ezáltal a HBM4 AI memóriagenerációnak rengeteg hely marad a folyamat és a teljesítmény javítására. A keletkező hőmennyiség kezelése érdekében a Samsung a magdobozokat és az adatátvitelt alacsony fogyasztású és alacsony feszültségű technológiákkal tervezte, így 30%-kal jobb hőelvezetést és 40%-kal nagyobb energiahatékonyságot ért el a HBM3 memóriagenerációhoz képest, amelyet az Nvidia most a Blackwell sorozatú AI grafikus kártyáiban használ.

A Samsung egyelőre maximum 36 GB HBM4 memóriakapacitást tud szállítani a vásárlóknak 12 rétegű stackelésen keresztül, de 16 rétegű stackelést is tud készíteni összesen 48 GB-ra, amikor az Nvidia készen áll a megfelelő GPU-k tervezésével és vásárlóerejével. A Samsung elég drága HBM4 chipet ígér, mondván, hogy"továbbra is biztosítja a stabil ellátási képességeket a növekvő közép- és hosszú távú kereslet kielégítésére, különösen az AI és az adatközpontok részéről", mivel 2026 második felében megkezdi a következő generációs HBM4E memória mintavételezését.

A 64 GB-os Crucial DDR5 laptop memóriakészlet beszerzése az Amazonon

Forrás(ok)

» A Top 10 multimédiás noteszgép - tesztek alapján

» A Top 10 játékos noteszgép

» A Top 10 belépő szintű üzleti noteszgép

» A Top 10 üzleti noteszgép

» A Top 10 notebook munkaállomása

» A Top 10 okostelefon - tesztek alapján

» A Top 10 táblagép

» A Top 10 Windows tabletje

» A Top 10 subnotebook - tesztek alapján

» A Top 10 300 euró alatti okostelefonja

» A Top 10 120 euró alatti okostelefonja

» A Top 10 phabletje (>5.5-inch)

» A Top 10 noteszgép 500 EUR (~160.000 HUF) alatt

» A Top 10 "pehelysúlyú" gaming notebookja